John von Neumann : comment on a appris aux machines à “travailler comme nous”

Quand on parle d’ordinateur aujourd’hui, on pense immédiatement à des notions devenues “normales” : processeur (CPU), mémoire (RAM), stockage, programmes, système d’exploitation, applications. Mais au début de l’informatique, rien de tout ça n’était évident. Et une question bloquait tout le monde : Comment construire une machine capable d’exécuter n’importe quel programme… sans devoir la recâbler à chaque fois ? C’est là qu’entre en scène John von Neumann.

John von Neumann : comment on a appris aux machines à “travailler comme nous”

Quand on parle d’ordinateur aujourd’hui, on pense immédiatement à des notions devenues “normales” : processeur (CPU), mémoire (RAM), stockage, programmes, système d’exploitation, applications.

Mais au début de l’informatique, rien de tout ça n’était évident. Et une question bloquait tout le monde :

Comment construire une machine capable d’exécuter n’importe quel programme… sans devoir la recâbler à chaque fois ?

C’est là qu’entre en scène John von Neumann.

Qui était John von Neumann ?

John von Neumann (1903–1957) était un scientifique hors normes : mathématicien, physicien, et pionnier de l’informatique. Il a travaillé sur des sujets très variés, dont :

-

les premiers ordinateurs

-

la théorie des jeux

-

la logique et le calcul

-

des travaux liés aux projets scientifiques et militaires de son époque

Mais son apport le plus connu en informatique est celui-ci :

il a posé l’un des modèles d’architecture qui a influencé la conception de la majorité des ordinateurs modernes.

Le problème avant von Neumann, version “vie réelle”

Les premières machines étaient souvent conçues pour une tâche précise.

Une machine = un programme.

Tu voulais changer de calcul ? Il ne suffisait pas de “lancer un autre programme”.

Il fallait modifier la machine : câbles, connexions, réglages physiques.

En langage simple : c’était comme vouloir changer une recette… en démontant la cuisine et en recâblant le four.

Impossible de construire une informatique flexible et évolutive avec un fonctionnement pareil.

L’idée géniale de von Neumann

Von Neumann propose une idée simple, mais révolutionnaire :

Et si les instructions (le programme) étaient stockées en mémoire, exactement comme les données ?

Autrement dit :

-

les données sont en mémoire

-

les instructions sont en mémoire

-

le processeur lit les deux

Conséquence directe : on peut changer de programme en changeant ce qui est stocké en mémoire, sans toucher au matériel.

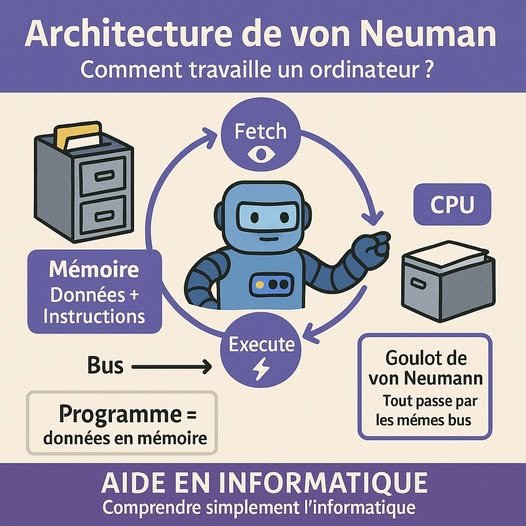

L’architecture von Neumann, expliquée “terre-à-terre”

Imagine une petite entreprise.

La mémoire (RAM)

C’est le bureau où sont posés :

-

les dossiers (les données)

-

les consignes de travail (les instructions)

Le CPU

C’est l’ouvrier très rapide, mais littéral :

-

il ne “devine” rien

-

il exécute exactement ce qu’on lui demande

Les bus (les connexions)

Ce sont les couloirs qui transportent :

-

données

-

instructions

-

résultats

Le cycle qui tourne en boucle

Le processeur répète en permanence :

-

Fetch : il va chercher une instruction en mémoire

-

Decode : il comprend quoi faire

-

Execute : il exécute l’ordre

Encore et encore, des millions à des milliards de fois par seconde.

C’est ce principe qui structure encore une grande partie du fonctionnement des machines modernes.

Pourquoi cette architecture a tout changé

Grâce à ce modèle, on a pu construire des machines généralistes :

-

on change de programme sans changer la machine

-

les langages de programmation deviennent possibles à grande échelle

-

les systèmes d’exploitation prennent tout leur sens

-

un même ordinateur peut faire du calcul, du texte, du réseau, du multimédia, du cloud, et bien plus

En clair : le matériel devient une base générale, et le logiciel fait le reste.

Le “goulot d’étranglement” de von Neumann

Ce modèle a aussi une limite classique :

instructions et données passent souvent par les mêmes “couloirs”, ce qui peut créer une forme d’embouteillage.

C’est ce qu’on appelle le goulot d’étranglement de von Neumann.

Pour le contourner, on a inventé et amélioré :

-

les caches (L1/L2/L3)

-

des variantes d’architectures (comme l’approche Harvard/modifiée selon les contextes)

-

le parallélisme

-

les GPU et accélérateurs

Mais malgré toutes ces évolutions, la base conceptuelle reste extrêmement présente.

Son impact aujourd’hui, très concret

Quand tu écris une ligne de code, que tu lances une application, qu’un serveur démarre ou qu’un modèle d’IA s’exécute, il y a toujours cette logique de fond :

-

mémoire

-

instructions stockées

-

exécution par un processeur

-

cycle fetch–decode–execute

Les architectures modernes sont souvent des évolutions et optimisations, pas une rupture totale avec ce modèle.

À retenir

Alan Turing a posé les bases théoriques du calcul.

Von Neumann a proposé une manière structurée de le faire tourner sur une machine réelle.

Sans cette idée de programme stocké en mémoire, l’informatique n’aurait pas pris la forme “flexible” et universelle qu’on connaît aujourd’hui.

Si vous aimez ce format “sous le capot” avec des analogies simples, retrouvez nos ressources et liens utiles Aide en Informatique dans la section dédiée du blog.

Et vous : aviez-vous déjà entendu parler de l’architecture von Neumann avant ce post ?

Quelle est votre réaction?